Lesezeit

3 Minuten

Seite 2 - Cloud Migration Planning: Der steinige Weg in die Wolke

Phase 2: Die Migrationsphase

Die Datenmigration selbst ist sorgfältig vorzubereiten und kann eine echte Herausforderung sein. In dieser Phase sollte es zu folgenden Überlegungen kommen:

Abhängig von der Menge der zu transferierenden Daten kann die Ausfallzeit zwischen wenigen Stunden und mehreren Tagen variieren. Die bidirektionale Datensynchronisation bietet zweifellos eine große Flexibilität, denn sie ermöglicht es die Migration vollständig rückgängig zu machen, sollte es zu Problemen kommen. Mit dieser Entscheidung sollten IT-Verantwortliche jedoch mit einkalkulieren, dass sie diesen Vorteil mit Performance-Einbußen, mehr Komplexität und zusätzlichen Kosten erkaufen. Wer Managed Database in der Cloud nutzen möchte, sollte sich unbedingt die Datenmigrationsdienste von AWS, Azure und Google genauer ansehen. Gute Planung und der Komplexität angemessene Ressourcen sind das A und O. Wer hierbei ungenau vorgeht, kann sich sicher sein zu scheitern und die entsprechenden Mehrkosten zu haben.

Phase 3: Die Transformationsphase

Transformation ist insbesondere im IT-Bereich kein neues Phänomen. Auch in den Zeiten klassischer IT gab es umfassende Updates oder sogar Wechsel zu anderen Anwendungen. Das Hauptproblem für Unternehmen besteht vielmehr darin, dass solche Phasen viele IT-Mitarbeiter binden, und diese fehlenden Ressourcen das Unternehmen an anderer Stelle ausbremsen. Angesichts des Fachkräftemangels und des prognostizierten Wachstums des Cloudmarktes ist klar, dass sich diese Situation auf absehbare Zeit nicht verbessern wird.

Sobald die Anwendungen in der Cloud laufen, ist als Erstes die Migration in der neuen Umgebung zu validieren. Dies sollte zügig geschehen, da nun 100 Prozent des Datenverkehrs über die neue Instanz laufen und die alte Infrastruktur stillgelegt wird. Danach folgt eine kontinuierliche Überwachungs- und Optimierungsschleife. Im Gegensatz zu On-Premises-Workloads sind Cloudumgebungen viel dynamischer und laufen ständig Gefahr, zu hohe Kosten zu verursachen oder anfällig für neu entdeckte Schwachstellen zu sein, wenn die Umgebungen nicht kontinuierlich einer Überwachung und Verbesserung unterliegen.

Auch Leistung und Ressourcenverbrauch sind im Blick zu behalten. Jetzt ist der richtige Zeitpunkt, um bei Über- oder Unterdimensionierung entsprechend zu optimieren. Überprüft werden sollten zudem die verfügbaren Instance Types des Cloudanbieters. Möglicherweise ist eine Anwendung sehr Speicher- oder CPU-intensiv und die gewählte Instance kann den Workload gar nicht wie gewünscht liefern.

Häufige Probleme bei der Cloudmigration: Sicherheitsrisiken und unnötige Kosten

Vorschnelle Entscheidungen für bestimmte Cloudlösungen können für Unternehmen schnell teuer werden. Oft stellt sich erst im Nachhinein heraus, dass die ausgewählte Cloud doch nicht alle Anforderungen erfüllen konnte und vor allem nicht so kosteneffektiv ist, wie ursprünglich gedacht. Ein oft unterschätztes Beispiel sind Lizenzprobleme. Lizenzierungen in der Cloud sind komplex und oft eine verwirrende Mischung aus gerätebasierten Lizenzmodellen, Named-User-Lizenzen und auf die Zahl gleichzeitig zugreifender Anwender bezogene Concurrent-User-Lizenzen. Existierende On-Premises-Lizenzen lassen sich oft nicht ohne weiteres in die Cloud übertragen. Die Folge können böse Überraschungen in Form von Lizenzverletzungen und damit verbundenen Nachzahlungen in beträchtlicher Höhe sein.

Ein weiterer Tipp zur Optimierung der Cloudnutzung besteht darin sicherzustellen, dass die Instanzen korrekt dimensioniert sind und On-Power-Schedules haben. Dies kann das Risiko überraschender Mehrkosten minimieren und Organisationen zusätzlich helfen, ihren täglichen Bedarf zu überblicken. Generell sollten Workloads, die nicht 24/7 durchgängig benötigt werden, außerhalb der Geschäftszeiten automatisch abgeschaltet werden, um Energie und Kosten zu sparen.

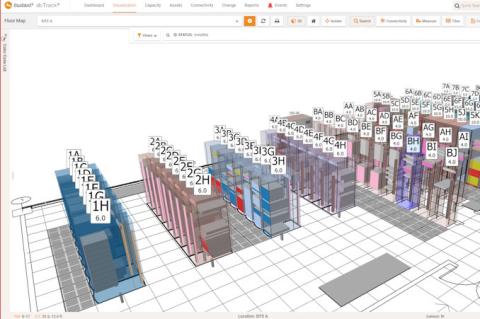

Deshalb liegt der Schlüssel zum Erfolg in einer umfassenden Transparenz aller SaaS-Anwendungen und Cloudinstanzen. Dies erreichen IT-Verantwortliche durch plattformneutrale Monitoringtools wie etwa Snow Commander, die für die globale Sichtbarkeit, Überwachung und Optimierung von Cloudumgebungen konzipiert sind. In einer zunehmend hybriden und Multicloud-Welt bieten die Standardtools einzelner Cloudanbieter nur eine begrenzte und unvollständige Übersicht. Viele Probleme mit Lizensierungen und Kosten für Cloudanwendungen und Cloudinfrastrukturen entstehen oft, weil niemand im Unternehmen den holistischen Überblick über die Gesamtumgebung hat.

Generell gilt: Es lässt sich nur das managen und optimieren, was bekennt ist. Dies beinhaltet insbesondere das Erkennen von gegebenenfalls redundanten Ressourcen. Doppelt lizenzierte oder beschaffte sowie ungenutzte SaaS-Anwendungen sind gerade in größeren Unternehmen keine Seltenheit. Beispielsweise finden neben Zoom auch noch Skype oder WebEx für Videokonferenzen Verwendung.

Derselbe mangelnde Überblick kann Herausforderungen bei der Minimierung von Sicherheitsrisiken mit sich bringen. Auch ungepatchte Sicherheitslücken können für Unternehmen, insbesondere in Zeiten der DSGVO, schnell katastrophale Datenpannen und hohe Strafen bedeuten. Das gilt ebenso in der Cloud. Wer wissen will, wie gefährlich eine entdeckte Schwachstelle für die eigene IT ist, muss die Prozesse; Software und Applikationen im Unternehmen kennen, auf die sie sich auswirkt. Sogenannte blinde Flecken und Schatten-IT, also Bereiche, auf die IT-Abteilungen mit ihren Security-Tools keinen Zugriff haben, gilt es zu minimieren und unter Kontrolle zu bringen.

Fazit

Der Weg in die Cloud ist sinnvoll, aber nicht immer einfach. Der Schlüssel zu einer erfolgreichen Cloudmigration liegt in der richtigen Vorbereitung. Dazu zählen die Zusammenstellung des richtigen Expertenteams, die Definition geeigneter KPIs, die Erstellung eines Plans zur Bewertung der zu migrierenden Daten, Anwendungen oder Software, sowie die Validierung und regelmäßige Überwachung der Auswirkungen wie auch der richtigen Geschwindigkeit der Migration. Ebenso wichtig ist die systematische Umsetzung anhand des entworfenen Plans zu jedem Zeitpunkt des gesamten Projekts. Es muss sichergestellt sein, dass alle implementierten Änderungen tatsächlich die Leistung, Verfügbarkeit und Customer Experience verbessern und keine unnötigen Kosten oder Sicherheitslücken verursachen.

ln/Jesse Stockall, Chief Architect Cloud Management bei Snow Software

Die Datenmigration selbst ist sorgfältig vorzubereiten und kann eine echte Herausforderung sein. In dieser Phase sollte es zu folgenden Überlegungen kommen:

- Wie werden Daten zwischen dem lokalen Rechenzentrum und der Cloud synchronisiert?

- Soll die Anwendung in einem definierten Wartungsfenster vollständig und für alle Nutzer gleichzeitig migriert werden?

- Ist es sinnvoll, zunächst nur ausgewählte Nutzer in die Cloud zu übertragen und anschließend eine Validierung durchzuführen?

Abhängig von der Menge der zu transferierenden Daten kann die Ausfallzeit zwischen wenigen Stunden und mehreren Tagen variieren. Die bidirektionale Datensynchronisation bietet zweifellos eine große Flexibilität, denn sie ermöglicht es die Migration vollständig rückgängig zu machen, sollte es zu Problemen kommen. Mit dieser Entscheidung sollten IT-Verantwortliche jedoch mit einkalkulieren, dass sie diesen Vorteil mit Performance-Einbußen, mehr Komplexität und zusätzlichen Kosten erkaufen. Wer Managed Database in der Cloud nutzen möchte, sollte sich unbedingt die Datenmigrationsdienste von AWS, Azure und Google genauer ansehen. Gute Planung und der Komplexität angemessene Ressourcen sind das A und O. Wer hierbei ungenau vorgeht, kann sich sicher sein zu scheitern und die entsprechenden Mehrkosten zu haben.

Phase 3: Die Transformationsphase

Transformation ist insbesondere im IT-Bereich kein neues Phänomen. Auch in den Zeiten klassischer IT gab es umfassende Updates oder sogar Wechsel zu anderen Anwendungen. Das Hauptproblem für Unternehmen besteht vielmehr darin, dass solche Phasen viele IT-Mitarbeiter binden, und diese fehlenden Ressourcen das Unternehmen an anderer Stelle ausbremsen. Angesichts des Fachkräftemangels und des prognostizierten Wachstums des Cloudmarktes ist klar, dass sich diese Situation auf absehbare Zeit nicht verbessern wird.

Sobald die Anwendungen in der Cloud laufen, ist als Erstes die Migration in der neuen Umgebung zu validieren. Dies sollte zügig geschehen, da nun 100 Prozent des Datenverkehrs über die neue Instanz laufen und die alte Infrastruktur stillgelegt wird. Danach folgt eine kontinuierliche Überwachungs- und Optimierungsschleife. Im Gegensatz zu On-Premises-Workloads sind Cloudumgebungen viel dynamischer und laufen ständig Gefahr, zu hohe Kosten zu verursachen oder anfällig für neu entdeckte Schwachstellen zu sein, wenn die Umgebungen nicht kontinuierlich einer Überwachung und Verbesserung unterliegen.

Auch Leistung und Ressourcenverbrauch sind im Blick zu behalten. Jetzt ist der richtige Zeitpunkt, um bei Über- oder Unterdimensionierung entsprechend zu optimieren. Überprüft werden sollten zudem die verfügbaren Instance Types des Cloudanbieters. Möglicherweise ist eine Anwendung sehr Speicher- oder CPU-intensiv und die gewählte Instance kann den Workload gar nicht wie gewünscht liefern.

Häufige Probleme bei der Cloudmigration: Sicherheitsrisiken und unnötige Kosten

Vorschnelle Entscheidungen für bestimmte Cloudlösungen können für Unternehmen schnell teuer werden. Oft stellt sich erst im Nachhinein heraus, dass die ausgewählte Cloud doch nicht alle Anforderungen erfüllen konnte und vor allem nicht so kosteneffektiv ist, wie ursprünglich gedacht. Ein oft unterschätztes Beispiel sind Lizenzprobleme. Lizenzierungen in der Cloud sind komplex und oft eine verwirrende Mischung aus gerätebasierten Lizenzmodellen, Named-User-Lizenzen und auf die Zahl gleichzeitig zugreifender Anwender bezogene Concurrent-User-Lizenzen. Existierende On-Premises-Lizenzen lassen sich oft nicht ohne weiteres in die Cloud übertragen. Die Folge können böse Überraschungen in Form von Lizenzverletzungen und damit verbundenen Nachzahlungen in beträchtlicher Höhe sein.

Ein weiterer Tipp zur Optimierung der Cloudnutzung besteht darin sicherzustellen, dass die Instanzen korrekt dimensioniert sind und On-Power-Schedules haben. Dies kann das Risiko überraschender Mehrkosten minimieren und Organisationen zusätzlich helfen, ihren täglichen Bedarf zu überblicken. Generell sollten Workloads, die nicht 24/7 durchgängig benötigt werden, außerhalb der Geschäftszeiten automatisch abgeschaltet werden, um Energie und Kosten zu sparen.

Deshalb liegt der Schlüssel zum Erfolg in einer umfassenden Transparenz aller SaaS-Anwendungen und Cloudinstanzen. Dies erreichen IT-Verantwortliche durch plattformneutrale Monitoringtools wie etwa Snow Commander, die für die globale Sichtbarkeit, Überwachung und Optimierung von Cloudumgebungen konzipiert sind. In einer zunehmend hybriden und Multicloud-Welt bieten die Standardtools einzelner Cloudanbieter nur eine begrenzte und unvollständige Übersicht. Viele Probleme mit Lizensierungen und Kosten für Cloudanwendungen und Cloudinfrastrukturen entstehen oft, weil niemand im Unternehmen den holistischen Überblick über die Gesamtumgebung hat.

Generell gilt: Es lässt sich nur das managen und optimieren, was bekennt ist. Dies beinhaltet insbesondere das Erkennen von gegebenenfalls redundanten Ressourcen. Doppelt lizenzierte oder beschaffte sowie ungenutzte SaaS-Anwendungen sind gerade in größeren Unternehmen keine Seltenheit. Beispielsweise finden neben Zoom auch noch Skype oder WebEx für Videokonferenzen Verwendung.

Derselbe mangelnde Überblick kann Herausforderungen bei der Minimierung von Sicherheitsrisiken mit sich bringen. Auch ungepatchte Sicherheitslücken können für Unternehmen, insbesondere in Zeiten der DSGVO, schnell katastrophale Datenpannen und hohe Strafen bedeuten. Das gilt ebenso in der Cloud. Wer wissen will, wie gefährlich eine entdeckte Schwachstelle für die eigene IT ist, muss die Prozesse; Software und Applikationen im Unternehmen kennen, auf die sie sich auswirkt. Sogenannte blinde Flecken und Schatten-IT, also Bereiche, auf die IT-Abteilungen mit ihren Security-Tools keinen Zugriff haben, gilt es zu minimieren und unter Kontrolle zu bringen.

Fazit

Der Weg in die Cloud ist sinnvoll, aber nicht immer einfach. Der Schlüssel zu einer erfolgreichen Cloudmigration liegt in der richtigen Vorbereitung. Dazu zählen die Zusammenstellung des richtigen Expertenteams, die Definition geeigneter KPIs, die Erstellung eines Plans zur Bewertung der zu migrierenden Daten, Anwendungen oder Software, sowie die Validierung und regelmäßige Überwachung der Auswirkungen wie auch der richtigen Geschwindigkeit der Migration. Ebenso wichtig ist die systematische Umsetzung anhand des entworfenen Plans zu jedem Zeitpunkt des gesamten Projekts. Es muss sichergestellt sein, dass alle implementierten Änderungen tatsächlich die Leistung, Verfügbarkeit und Customer Experience verbessern und keine unnötigen Kosten oder Sicherheitslücken verursachen.

ln/Jesse Stockall, Chief Architect Cloud Management bei Snow Software