Aufgaben eines modernen Monitorings (2)

Monitoring ist die unmittelbare systematische Erfassung, Beobachtung oder Überwachung eines Vorgangs oder Prozesses mittels technischer Hilfsmittel. So schlicht die Definition ist, so komplex sind die Missverständnisse, die dieses Thema zwischen Business und IT aufwirft. Dabei hilft richtig verstandenes und betriebenes Monitoring Unternehmen in allen Geschäftsbereichen. Im zweiten Teil dieses Artikels gehen wir auf die Aufgaben des Monitorings, die Anforderungen an Überwachungswerkzeuge und Monitoring in der Cloud ein.

Aufgaben des Monitorings

Eine Funktion des Monitorings besteht darin, bei einem beobachteten Ablauf prozesssteuernd einzugreifen, sofern dieser nicht den gewünschten Verlauf nimmt oder bestimmte Schwellenwerte unterbeziehungsweise überschritten sind. Das Monitoring ist deshalb auch als ein Sondertyp des Protokollierens zu verstehen. Das Monitoring umfasst sämtliche Bereiche der IT, inklusive Hard- und Software, Anwendungen, Sicherheit, Verfügbarkeit oder auch Nutzungsverhalten von Anwendern.

Ohne die Kenntnis der zu überwachenden Parameter lassen diese sich auch nicht verwalten und einhalten. Aus diesem Grund ist als eines der obersten Ziele des Monitorings das Abweichen bestimmter Parameter außerhalb gewünschter Wirkungsbereiche zu verstehen. Dabei dient das Monitoring dazu:

- Die Abweichungen zwischen den definierten Istzuständen und den Sollzuständen festzustellen, zu beurteilen und Probleme so rechtzeitig zu erkennen, dass diese beseitigt werden können, bevor größere Schäden entstehen.

- Fehleridentifizierung, Fehlerlokalisierung und Fehlervermeidung sowie Erlangung von Informationen, die der Entscheidungsverbesserung all derjenigen dienen können, die über das Ergebnis der Überwachung unterrichtet werden.

- Durch Know-how-Gewinn zukünftige Probleme schneller erkennen und eventuell sogar vermeiden zu können.

- Zur Prüfung (Revision) und Kontrolle bestimmter IT-Parameter und zur Dokumentation der Einhaltung bestimmter (gesetzlicher) Vorgaben.

- Aufzeichnung von (Langzeit-) Statistiken zur Kapazitätsplanung beziehungsweise der Aufzeichnung von Nutzungsdaten zur Abrechnung.

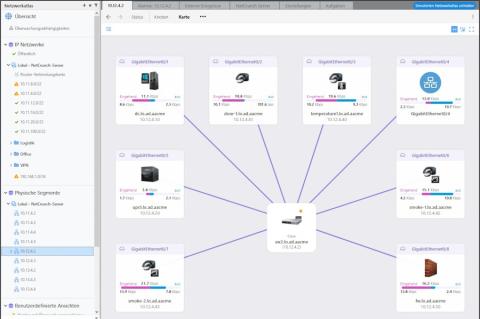

In der Praxis unterteilt sich das IT-Monitoring in weitere Einzeldisziplinen, beginnend mit dem Netzwerk-Monitoring, das die Überwachung und regelmäßige Kontrolle von Netzwerken, deren Hardware (Server, Switchen, Router, Gateways) und Dienste (Domain Name Service, E-Mail et cetera) umfasst. Wir unterscheiden hierbei zwischen externem und internem Monitoring.

Beim Web-Monitoring handelt es sich um die zielgerichtete Beobachtung, Extraktion, Analyse und Aufbereitung von Ressourcen des World Wide Web. Meist wird das Web-Monitoring zur Überwachen der unternehmenseigenen Webseite genutzt. Dabei wird die Funktionalität beziehungsweise die Performance aus Sicht eines externen Nutzers überprüft. Das Service-Monitoring dient dazu, über spezielle Programme (Agenten) auf den Servern eines Unternehmens die auf dem Server laufenden Server-Programme auf Funktion zu überprüfen und unter Umständen ermittelte Fehler zu korrigieren.

Der Begriff "Business Monitoring" bezeichnet die Sammlung von Analysen und Präsentationen über zeitrelevante Geschäftsprozesse in Unternehmen. Es bietet detaillierte Informationen über den Status und die Ergebnisse von verschiedensten Operationen, Prozessen und Transaktionen, sodass Geschäftsentscheidungen vorbereitet und Probleme schnell adressiert werden können.

Eine typische Software in diesem Bereich ist beispielsweise in der Lage, sofortige Aussagen über den Zustand von Geschäftsprozessen auf Systemebene zu liefern (Geschäftsprozess überlastet, hohe Antwortzeiten aus Endbenutzersicht, Überschreitung von Service Level Agreements) und diese an die zuständigen Instanzen zu melden. Sie dient so als Überwachungswerkzeug für Geschäftsprozesse auf Systemebene.

Und zu guter Letzt umfasst das Sicherheitsmonitoring die Überwachung der eigentlichen Sicherheitssysteme, die Identifizierung von ungewöhnlichen Vorkommnissen und die Überprüfung der Umgebungsparameter. Stellt das Monitoring einen Ausfall oder ungewöhnliche Vorgänge fest, sendet dieses Werkzeug einen Alarm (per SMS oder E-Mail) an den zuständigen Systemadministrator und dieser kann schnell auf den Vorfall reagieren. Ein Sicherheitsmonitoring basiert auf entsprechend definierten Schwellenwerten. Werden diese überschritten, reagiert die Software mit einem entsprechenden Alarm. Eine wichtige Aufgabe des Monitorings besteht darin, die im Unternehmen aktiven Sicherheitssysteme (Firewalls, Virenscanner et cetera) auf ihre Funktionstüchtigkeit zu überprüfen.

Anforderungen an ein Monitoring-Werkzeug

Eine Monitoring-Lösung dient grundsätzlich dazu, die gesamte IT-Infrastruktur mit allen Geräten und Systemen im Auge zu behalten. Prinzipiell können Administratoren alles überwachen, was über eine definierte Schnittstelle verfügt und via Standardprotokoll Informationen über den eigenen Zustand liefert. Die Monitoring-Software muss dazu lediglich über eine IP-Adresse mit dem Gerät oder Dienst Kontakt aufnehmen und kann dann den aktuellen Gerätezustand abfragen.

So ist der IT-Verantwortliche in der Lage, den Status nahezu jedes beliebigen Bereiches seiner IT-Infrastruktur rund um die Uhr im Blick zu behalten. Das Ziel ist es, die maximale Verfügbarkeit und die optimale Performance im Netzwerk und auf den daran angeschlossenen Systemen zu erreichen. Ein Monitoring-Werkzeug sollte seinen Beitrag zur Beantwortung folgender Fragen liefern:

- Arbeiten alle aktiven Hardware-Komponenten gleichbleibend gut?

- Sind alle Server und Services aktiv?

- Funktionieren die Sicherheitsfunktionen im Netzwerk?

- Arbeiten die Webseiten und der Online-Shop einwandfrei?

- Gibt es Störungen bei Voice-over-IP-Verbindungen oder Video-Streams?

- Liefern die Datenbanken die gewünschte Performance?

- Wie finde ich Fehlerquellen in virtualisierten Umgebungen?

- Habe ich alle laufenden Backups im Blick?

- Sind die Drucker jederzeit arbeitsbereit?

- Reagieren die Cloud-Dienste innerhalb der vereinbarten SLAs?

Zu den Aufgaben eines Administrators gehört es, die installierten Hardware-Komponenten (CPUs, Speichergeräte, Server und so weiter) und die Netzinfrastrukturen kontinuierlich zu prüfen. Eine Monitoring-Lösung überwacht den Status dieser Komponenten und liefert bei Bedarf detaillierte Analysedaten und Langzeitberichte. Anhand dieser gesammelten Informationen kann der Administrator bestimmte Trends erkennen und den Optimierungsbedarf bestimmen. Das Monitoring informiert beziehungsweise alarmiert den zuständigen Administrator bei der Über- oder Unterschreitung der eingerichteten Schwellenwerte. Auf diese Weise ist der Administrator in der Lage, nicht nur reaktiv zu agieren, sondern seine Aufgaben vorausschauend zu gestalten.

Hohe Temperaturen, Feuchtigkeit, Wasserlecks, Feuer, Rauch et cetera könnten die Ausrüstung eines Serverraums oder eines Rechenzentrums beschädigen. Zur Sicherstellung des Betriebs sollten daher die signifikanten Umgebungsparameter überwacht werden. Entsprechende Sensoren für Temperatur, Feuchtigkeit et cetera sind in die Monitoring-Lösung zu integrieren. Registrieren sie ungewöhnlich hohe Werte, wird an den zuständigen Administrator eine Alarmmeldung geschickt (E-Mail, SMS oder sonstiger Nachrichtendienst). Eine solche Monitoring-Lösung kann auch die Funktion aller installierten Überwachungskameras prüfen oder die Verriegelung von Fenster und Türen, wenn die Mitarbeiter am Abend das Gebäude verlassen.

Monitoring trifft Cloud

Für viele Unternehmen und besonders für die Möglichkeiten der Geschäftsprozesse definiert heute die Cloud den IT-Horizont. Trotz aller Jubelarien der Cloud werden die Zuverlässigkeit, die Sicherheit und sogar die Datenverluste immer der Unternehmens-IT zugeschrieben. Das Problem für IT-Abteilungen besteht darin, dass die Cloud die Kontrollfunktionen drastisch einschränkt.

Die Cloud schafft auch ein völlig neues Problem: An welchen Kriterien misst das Unternehmen IT-Ausgaben der Business-Anwender, wenn die Cloud Services ohne die Beteiligung (Kontrolle) der Unternehmens-IT genutzt werden? Die Business-Anwender nutzen ihre Freiheiten zusehends. Zum ersten Mal haben diese die Wahl zwischen den IT-Services des eigenen Unternehmens und der Konkurrenz der Cloud-Anbieter. Der Vorteil liegt eindeutig bei der Cloud. Bis die eigene IT-Abteilung auf die Anforderungen der Nutzer reagieren kann, vergeht in der Regel viel Zeit. Die Cloud-Dienste stehen in der Regel schnell und unbürokratisch zur Verfügung. Zwangsläufig entsteht dadurch eine noch größere Schatten-IT in den Unternehmen, und die Kontrolle aller Dienste und Services wird für die verantwortlichen Abteilungen immer schwerer.

Ohne technologisches Wissen und ohne externe Beratung lassen sich Geschäftsanwendungen mit Hilfe von Cloud-Services aktivieren und betreiben. Der Nutzer benötigt nur eine Kreditkarte und mit einigen Klicks im dargebotenen Menü des Anbieters ist der betreffende Dienst oder die Anwendung aktiviert und einsatzfähig. Die Unternehmens-IT hat spätestens zu diesem Zeitpunkt die Kontrolle über diese Prozesse verloren. Die Cloud und die mobile Anwendungen stellen den frustrierten Business-Anwendern den notwendigen Zugang zu Technologieressourcen bereit, ohne dabei die eigene Unternehmens-IT in Anspruch nehmen zu müssen.

Die IT-Abteilungen müssen erkennen, dass sich ihre Welt drastisch wandelt. Ihre Aufgabe besteht nicht mehr darin, diktatorisch den Nutzern ihre Geschäftsanwendungen und -lösungen vorzusetzen, sondern die IT muss bei der Suche nach den richtigen Konzepten einen wichtigen Beitrag leisten. Anstatt die Cloud und die Anwenderlösungen zu bekämpfen, geht es darum, die Kontrolle zurückzugewinnen. Im Vordergrund aller Bemühungen der IT-Abteilungen muss das Wertvollste im Unternehmen stehen: Einfluss. Die Tage der allmächtigen IT-Abteilungen sind gezählt und von den Anwendern werden keine diktierten Methoden und Geräte mehr akzeptiert. Je früher die IT-Abteilungen diese Tatsache anerkennen, desto schneller können diese wieder ein gewisses Maß an Kontrolle gewinnen.

Solche dynamischen IT-Infrastrukturen wurden erst durch eine Virtualisierung der Server-Systeme möglich. Monitoring-Lösungen stellen in der Regel unterschiedliche Sensoren zur Überwachung virtualisierter Umgebungen bereit. Damit lassen sich beispielsweise die CPU- und Speicherauslastung, die Netzwerkgeschwindigkeit sowie die Gesamtperformance virtueller Maschinen überprüfen. Auch der Status der einzelnen Server kann überwacht werden, damit sofort erkennbar ist, ob das Problem in der virtuellen Maschine oder vom jeweiligen Server verursacht wird.

Über das Unternehmensnetz greifen die Mitarbeiter auf unzählige Daten zu. Geringe Durchsatzleistungen im Netzwerk beziehungsweise Probleme mit den Datenbanken lähmen die Arbeitsprozesse. Schwankt die Performance von Datenbanken, müssen die Ursachen hierfür gefunden werden. Eine Monitoring-Lösung zeigt beispielsweise die Anzahl der aktuellen Nutzerverbindungen an und gibt damit Hinweise zur Fehleranalyse. Eventuell nutzen zu bestimmten Zeiten zu viele Anwender eine Ressource. Ist dies der Fall, kann der Administrator beispielsweise den verfügbaren Speicher auf dem SQL-Server erhöhen und das Problem aus der Welt zu schaffen.

Zunehmend werden in den Unternehmen die IT-Strukturen auch offiziell durch Clouds (private oder öffentliche Cloud) ersetzt oder ergänzt. Vor dem Umzug in die Cloud muss ermittelt werden, welche Leistungsansprüche der Applikationen und welche zyklischen Schwankungen zu erwarten sind. Anhand der von einer Monitoring-Lösung bereitgestellten Langzeitanalysen, Trends und Lastspitzen lassen sich die in der Cloud erforderlichen Ressourcen bedarfsgerecht planen.

Eine Cloud funktioniert jedoch nur dann reibungslos, wenn ein schnelles und hochgradig zuverlässiges Netzwerk die physischen Server verbindet. Aus diesem Grund muss die gesamte Netzinfrastruktur vor der Realisierung der Cloud eingehend analysiert werden. Die Systemleistung in Bezug auf Übertragungsgeschwindigkeit und Stabilität muss den Anforderungen entsprechen, andernfalls sind Hardware oder Netzanbindungen aufzurüsten. Als Konsequenz rückt damit das Monitoring der Netz-Performance in den Mittelpunkt sämtlicherAktivitäten.

Im ersten Teil der Artikels hatten wir uns an eine erste Bestandsaufnahme zum Thema Monitoring in der Unternehmens-IT gemacht

Der dritte Teil der Serie beschäftigt sich mit Sicherheitsmonitoring und der Überwachung von Echtzeitapplikationen.

jp/ln