Lesezeit

4 Minuten

Best Practices für das Monitoring der Endpoint-Performance

Probleme bei der IT-Performance in Unternehmen werden häufig sehr spät erkannt und dann meist nur auf Einzelfallbasis behoben. Hauptgrund für dieses Vorgehen nach dem Flickenteppich-Prinzip ist das Fehlen einer zentralen, systematischen Übersicht über den Zustand der gesamten IT-Infrastruktur. Mit einem agentenbasierten Werkzeug für das Performancemanagement können IT-Verantwortliche komplexe und ressourcenintensive Insellösungen ersetzen und damit Mitarbeiter und Hardware gleichermaßen entlasten.

Bei der Untersuchung von Performanceproblemen greifen IT-Verantwortliche häufig auf manuelle Fehlerbehebungsprozesse zurück. Allerdings scheitert dieser Ansatz an der Identifizierung der eigentlichen Ursache, da es an historischen Daten mangelt. Darüber hinaus sind Insellösungen zu kostspielig für den Business-Einsatz, da sie zusätzliche Agenten, Infrastruktur und Investitionen in die Wartung erfordern. Erschwerend kommt hinzu, dass Organisationen oftmals erst dann einen detaillierten Blick auf die Leistung der IT werfen, wenn Probleme auftreten. Dabei kann es sich allerdings nur um einen Bruchteil der auftretenden Fälle handeln. In der Zwischenzeit leidet die Produktivität.

Defizite in der Leistungsüberwachung aufgrund mangelnder Transparenz der Endpunkte erhöhen die Wahrscheinlichkeit nicht gemeldeter oder diagnostizierter Probleme. Die Analyse von Endpunkt-Performancedaten ist unerlässlich, da sie kritische Problemstellen aufdecken kann, wie etwa Speicherlecks, die durch kürzliche Software-Updates verursacht wurden, falsch konfigurierte Antiviren-Software, die zu viele Ressourcen verbraucht, Fertigungsfehler bei neuer Hardware oder Anomalien, die auf Sicherheitsrisiken hinweisen. Idealerweise sollte die Überwachung selbst die Leistung der Endpunkte oder des Netzwerks nicht beeinträchtigen – was jedoch nicht bei allen verfügbaren Produkten der Fall ist.

Folgende Best Practices gewährleisten ein effizientes und effektives Performancemonitoring von Computern, Servern und anderen Endgeräten. Darüber hinaus lassen sich damit auch Sicherheitslücken und andere Bedrohungen viel früher erkennen und angehen.

Überwachung sämtlicher Arten von Endpunkten

Sind 90 Prozent der Endgeräte im Unternehmen Windows-Rechner, ist es kaum verwunderlich, dass der Großteil der Investitionen in Tools zur Überwachung dieser Rechner fließt und die Prozesse sich danach ausrichten. Doch was geschieht mit den Linux-Servern und Macs, die sich in den Home Offices der Mitarbeiter befinden? Sich hier allein auf die Funktionalität der Geräte zu verlassen, wäre fatal – selbst dann, wenn es kaum Beschwerden über die Performance gibt. Denn Probleme an einem dieser Rechner können Auswirkungen auf den gesamten Workflow haben und somit viele Mitarbeiter direkt oder indirekt beeinflussen. Daher muss sichergestellt sein, dass IT-Teams über Tools und Prozesse verfügen, um alle Arten von Endgeräten im Unternehmen zu überwachen.

Wirklich alle Endpunkte lokalisieren

Selbst wenn IT-Verantwortliche über die entsprechenden Tools verfügen, um alle Arten von Endpunkten im Unternehmen zu überwachen, bedeutet dies nicht, dass keine Geräte übersehen werden können. Denn leider mangelt es oft an vollständiger Transparenz und Kontrolle über das gesamte (dezentrale) Netzwerk. Endpunkte, die aus dem Raster der IT-Teams fallen, könnten Performanceprobleme aufweisen und dadurch die Produktivität des gesamten Unternehmens gefährden.

Den Überblick behalten

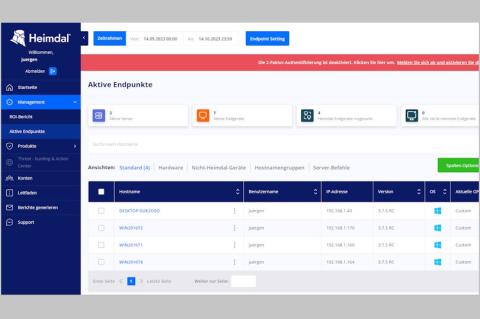

Jeden Endpunkt überwachen und kontrollieren zu können ist wichtig, allerdings noch keine Garantie dafür, dass den IT- und Unternehmensverantwortliche ein Gesamtüberblick über alle verwalteten Endpunkte gestattet ist. Für ein effektives Performancemonitoring ist eine Dashboard-Sicht entscheidend, die beispielsweise anzeigt, dass in Niederlassung A alles nach Plan läuft, während in Niederlassung B einige Geräte aufgrund von Fehlern im Zuge eines Updates nicht ordnungsgemäß funktionieren. Daher ist es wichtig, sowohl einen unternehmensweiten Überblick als auch einen genauen Einblick in die Endgeräte mit Leistungsproblemen zu haben.

Komplexität für die Endanwender reduzieren

Meldet ein Mitarbeiter ein Performanceproblem, muss er seine aktuelle Arbeit in der Regel erst einmal ruhen lassen. Denn klassische Überwachungsplattformen erfordern, dass IT-Teams vollen Zugriff auf die Systeme haben, um vorliegende Probleme zu beheben. Oftmals kann die Analyse erst dann beginnen, wenn der Mitarbeiter einer Diagnose- oder Fernsteuerungsanwendung zustimmt. Ist das Problem durch die Tätigkeit des Mitarbeiters verursacht worden, ist die optimale Gelegenheit der Fehlerbehebung bereits verstrichen. Eine bessere Lösung besteht in diesem Fall darin, den IT-Teams ein Tool zur Verfügung zu stellen, mit dem diese die Aktivitäten des Endpunkts analysieren können, ohne die Arbeit des Nutzers zu unterbrechen und ohne ihn zu bitten, Clients zu installieren, sich durch Dialogfelder zu klicken oder wertvolle Zeit am Telefon zu verbringen.

Lokal aufzeichnen, global troubleshooten

Ein Grund, warum so viele Performancemonitoring-Plattformen auf aufdringliche Untersuchungstechniken setzen, ist, dass sie nur wenig oder sogar gar keinen Zugriff auf Informationen zu Endpunktaktivitäten besitzen, solange keine Verbindung zu diesen Endpunkten über das Netzwerk hergestellt ist. Dieser Ansatz ist problematisch, weil er die Arbeit der Nutzer unterbricht und den Datenzugriff für IT-Teams einschränkt. Tritt ein Problem nur sporadisch auf oder steht es in Zusammenhang mit anderen Aktivitäten, die in den Stunden oder Tagen zuvor aufgetreten sind, könnte es übersehen werden. Die Alternative ist die lokale Aufzeichnung von Leistungsdaten der Endpunkte, sodass der IT bei der Analyse eine Fülle an Daten aus einem lokalen Datenspeicher zur Verfügung stehen.

Die Auswirkungen von Software- oder Hardware-Änderungen lassen sich oft nur durch längere Messung des Ressourcenverbrauchs und anderer Metriken feststellen.

Die Auswirkungen von Software- oder Hardware-Änderungen lassen sich oft nur durch längere Messung des Ressourcenverbrauchs und anderer Metriken feststellen.

Da diese Daten bereits vorliegen, gibt es keinen Grund, zur Behebung eines Problems die Arbeit der Nutzer zu unterbrechen. Die lokale Speicherung ermöglicht es den Technikern, auf die erforderlichen Daten zuzugreifen, ohne dass alle Endpunkte kontinuierlich detaillierte Metriken an eine zentrale Managementkonsole übertragen müssen. Performanceprobleme lassen sich auf diese Weise ohne große Netzwerkbelastung von jedem Standpunkt aus beheben: einem lokalen LAN oder WAN, einem Helpdesk-Center, einem Security Operations Control Center oder aus dem Home Office. Das Ergebnis: Besser Informationen für die Fehlersuche, schnellere Problemlösungen und ein komfortableres Handling – sowohl für die Endanwender als auch für die IT-Teams.

Mean-Time-to-Repair reduzieren

Mean-Time-to-Repair (MTTR) ist eine wichtige Ausfallmetrik, denn sie gibt die Zeitspanne an, die durchschnittlich für die Reparatur und Wiederherstellung der Funktionsfähigkeit einer Komponente oder eines Systems benötigt wird. Wie schnell können die IT-Teams ein Problem beheben? Lassen sich alle benötigten Informationen schnell und einfach finden – und zwar ohne die Produktivität der Mitarbeiter einzuschränken? Ein Blick auf die MTTR ermöglicht es Organisationen, den Wert ihrer Performancetools und -Verfahren zu bewerten. Wenn Mitarbeiter, Prozesse und Technologien, die für das Leistungsmonitoring Verwendung finden, die MTTR nicht reduzieren können, ist das ein Hinweis darauf, dass die Strategie überdacht werden sollte.

Fazit

Da viele Organisationen heute dezentral strukturiert sind und auf Insellösungen setzen, steigt die Komplexität. Um die Geschäftskontinuität nicht zu gefährden und die Produktivität aufrechtzuerhalten, gilt es, die Leistung aller Endpunkte kontinuierlich zu überwachen und eventuelle Probleme schnell und umfassend zu erkennen und zu beheben. Allerdings bieten traditionelle Tools zum Leistungsüberwachung keinen umfassenden Einblick in die Endpunktperformance. Oft fehlt es ihnen auch an ausreichender Funktionalität zur Fehlerbehebung und der Fähigkeit zur Skalierung. Moderne Werkzeuge hingegen entlasten die IT-Abteilung und fördern einen proaktiven, strategischen Ansatz: Sie generieren ein Echtzeitbild der Leistungsmetriken jedes Geräts, suchen proaktiv nach potenziellen Problemfeldern und ermöglichen die einfache Fehlerbehebung mit einem Klick für alle betroffenen Endgeräte.

ln/Christoph Volkmer, VP EMEA Central bei Tanium

Defizite in der Leistungsüberwachung aufgrund mangelnder Transparenz der Endpunkte erhöhen die Wahrscheinlichkeit nicht gemeldeter oder diagnostizierter Probleme. Die Analyse von Endpunkt-Performancedaten ist unerlässlich, da sie kritische Problemstellen aufdecken kann, wie etwa Speicherlecks, die durch kürzliche Software-Updates verursacht wurden, falsch konfigurierte Antiviren-Software, die zu viele Ressourcen verbraucht, Fertigungsfehler bei neuer Hardware oder Anomalien, die auf Sicherheitsrisiken hinweisen. Idealerweise sollte die Überwachung selbst die Leistung der Endpunkte oder des Netzwerks nicht beeinträchtigen – was jedoch nicht bei allen verfügbaren Produkten der Fall ist.

Folgende Best Practices gewährleisten ein effizientes und effektives Performancemonitoring von Computern, Servern und anderen Endgeräten. Darüber hinaus lassen sich damit auch Sicherheitslücken und andere Bedrohungen viel früher erkennen und angehen.

Überwachung sämtlicher Arten von Endpunkten

Sind 90 Prozent der Endgeräte im Unternehmen Windows-Rechner, ist es kaum verwunderlich, dass der Großteil der Investitionen in Tools zur Überwachung dieser Rechner fließt und die Prozesse sich danach ausrichten. Doch was geschieht mit den Linux-Servern und Macs, die sich in den Home Offices der Mitarbeiter befinden? Sich hier allein auf die Funktionalität der Geräte zu verlassen, wäre fatal – selbst dann, wenn es kaum Beschwerden über die Performance gibt. Denn Probleme an einem dieser Rechner können Auswirkungen auf den gesamten Workflow haben und somit viele Mitarbeiter direkt oder indirekt beeinflussen. Daher muss sichergestellt sein, dass IT-Teams über Tools und Prozesse verfügen, um alle Arten von Endgeräten im Unternehmen zu überwachen.

Wirklich alle Endpunkte lokalisieren

Selbst wenn IT-Verantwortliche über die entsprechenden Tools verfügen, um alle Arten von Endpunkten im Unternehmen zu überwachen, bedeutet dies nicht, dass keine Geräte übersehen werden können. Denn leider mangelt es oft an vollständiger Transparenz und Kontrolle über das gesamte (dezentrale) Netzwerk. Endpunkte, die aus dem Raster der IT-Teams fallen, könnten Performanceprobleme aufweisen und dadurch die Produktivität des gesamten Unternehmens gefährden.

Den Überblick behalten

Jeden Endpunkt überwachen und kontrollieren zu können ist wichtig, allerdings noch keine Garantie dafür, dass den IT- und Unternehmensverantwortliche ein Gesamtüberblick über alle verwalteten Endpunkte gestattet ist. Für ein effektives Performancemonitoring ist eine Dashboard-Sicht entscheidend, die beispielsweise anzeigt, dass in Niederlassung A alles nach Plan läuft, während in Niederlassung B einige Geräte aufgrund von Fehlern im Zuge eines Updates nicht ordnungsgemäß funktionieren. Daher ist es wichtig, sowohl einen unternehmensweiten Überblick als auch einen genauen Einblick in die Endgeräte mit Leistungsproblemen zu haben.

Komplexität für die Endanwender reduzieren

Meldet ein Mitarbeiter ein Performanceproblem, muss er seine aktuelle Arbeit in der Regel erst einmal ruhen lassen. Denn klassische Überwachungsplattformen erfordern, dass IT-Teams vollen Zugriff auf die Systeme haben, um vorliegende Probleme zu beheben. Oftmals kann die Analyse erst dann beginnen, wenn der Mitarbeiter einer Diagnose- oder Fernsteuerungsanwendung zustimmt. Ist das Problem durch die Tätigkeit des Mitarbeiters verursacht worden, ist die optimale Gelegenheit der Fehlerbehebung bereits verstrichen. Eine bessere Lösung besteht in diesem Fall darin, den IT-Teams ein Tool zur Verfügung zu stellen, mit dem diese die Aktivitäten des Endpunkts analysieren können, ohne die Arbeit des Nutzers zu unterbrechen und ohne ihn zu bitten, Clients zu installieren, sich durch Dialogfelder zu klicken oder wertvolle Zeit am Telefon zu verbringen.

Lokal aufzeichnen, global troubleshooten

Ein Grund, warum so viele Performancemonitoring-Plattformen auf aufdringliche Untersuchungstechniken setzen, ist, dass sie nur wenig oder sogar gar keinen Zugriff auf Informationen zu Endpunktaktivitäten besitzen, solange keine Verbindung zu diesen Endpunkten über das Netzwerk hergestellt ist. Dieser Ansatz ist problematisch, weil er die Arbeit der Nutzer unterbricht und den Datenzugriff für IT-Teams einschränkt. Tritt ein Problem nur sporadisch auf oder steht es in Zusammenhang mit anderen Aktivitäten, die in den Stunden oder Tagen zuvor aufgetreten sind, könnte es übersehen werden. Die Alternative ist die lokale Aufzeichnung von Leistungsdaten der Endpunkte, sodass der IT bei der Analyse eine Fülle an Daten aus einem lokalen Datenspeicher zur Verfügung stehen.

Da diese Daten bereits vorliegen, gibt es keinen Grund, zur Behebung eines Problems die Arbeit der Nutzer zu unterbrechen. Die lokale Speicherung ermöglicht es den Technikern, auf die erforderlichen Daten zuzugreifen, ohne dass alle Endpunkte kontinuierlich detaillierte Metriken an eine zentrale Managementkonsole übertragen müssen. Performanceprobleme lassen sich auf diese Weise ohne große Netzwerkbelastung von jedem Standpunkt aus beheben: einem lokalen LAN oder WAN, einem Helpdesk-Center, einem Security Operations Control Center oder aus dem Home Office. Das Ergebnis: Besser Informationen für die Fehlersuche, schnellere Problemlösungen und ein komfortableres Handling – sowohl für die Endanwender als auch für die IT-Teams.

Mean-Time-to-Repair reduzieren

Mean-Time-to-Repair (MTTR) ist eine wichtige Ausfallmetrik, denn sie gibt die Zeitspanne an, die durchschnittlich für die Reparatur und Wiederherstellung der Funktionsfähigkeit einer Komponente oder eines Systems benötigt wird. Wie schnell können die IT-Teams ein Problem beheben? Lassen sich alle benötigten Informationen schnell und einfach finden – und zwar ohne die Produktivität der Mitarbeiter einzuschränken? Ein Blick auf die MTTR ermöglicht es Organisationen, den Wert ihrer Performancetools und -Verfahren zu bewerten. Wenn Mitarbeiter, Prozesse und Technologien, die für das Leistungsmonitoring Verwendung finden, die MTTR nicht reduzieren können, ist das ein Hinweis darauf, dass die Strategie überdacht werden sollte.

Fazit

Da viele Organisationen heute dezentral strukturiert sind und auf Insellösungen setzen, steigt die Komplexität. Um die Geschäftskontinuität nicht zu gefährden und die Produktivität aufrechtzuerhalten, gilt es, die Leistung aller Endpunkte kontinuierlich zu überwachen und eventuelle Probleme schnell und umfassend zu erkennen und zu beheben. Allerdings bieten traditionelle Tools zum Leistungsüberwachung keinen umfassenden Einblick in die Endpunktperformance. Oft fehlt es ihnen auch an ausreichender Funktionalität zur Fehlerbehebung und der Fähigkeit zur Skalierung. Moderne Werkzeuge hingegen entlasten die IT-Abteilung und fördern einen proaktiven, strategischen Ansatz: Sie generieren ein Echtzeitbild der Leistungsmetriken jedes Geräts, suchen proaktiv nach potenziellen Problemfeldern und ermöglichen die einfache Fehlerbehebung mit einem Klick für alle betroffenen Endgeräte.

ln/Christoph Volkmer, VP EMEA Central bei Tanium