Zero Trust richtig umsetzen

Zero Trust ist mittlerweile state of the art in Sachen Sicherheit. Was dabei häufig unter den Tisch fällt: Ganzheitliche Sichtbarkeit – und zwar bis auf Netzwerkebene – ist die Grundvoraussetzung für das Konzept. Ausgerechnet hier scheitern bereits viele Unternehmen. Die Folge: Blind Spots nehmen ihnen die Sicht. Erfahren Sie im Fachbeitrag, warum Deep Observability bei einer Zero-Trust-Strategie nicht fehlen darf und wie sich Sicherheits- und Compliancerisiken damit proaktiv minimieren lassen.

Die Idee hinter Zero Trust ist eindeutig: Je eingeschränkter der Zugriff innerhalb des Netzwerks ist, desto sicherer geht es dort zu. Das Sicherheitsmodell basiert vornehmlich auf dem Misstrauen gegenüber Nutzern, Anwendungen und Geräten, die sich mit dem Unternehmensnetzwerk verbinden. Diese könnten schließlich unliebsame Besucher einschleusen. Ihr Zugang wird grundsätzlich auf das Minimum reduziert; nur ausgewählte Anwendungen und Mitarbeiter erhalten – abhängig von Rolle und Tätigkeit – mehr Zugriffsprivilegien. Über verschiedene Mechanismen wie Multifaktor-Authentifizierung wird geprüft, ob eine entsprechende Berechtigung vorliegt oder nicht.

Das Schutzprinzip von Zero Trust ist also vielversprechend. Kein Wunder, dass immer mehr Organisationen auf diesen Zug aufspringen wollen. Allerdings zeigt sich nun, dass viele IT- und Security-Teams gar nicht das notwendige Fundament für die Sicherheitsarchitektur mitbringen.

Komplexität und blinde Flecken: Ein gefundenes Fressen für Cyberkriminelle

Die Bedrohungslandschaft wird stetig größer, vielfältiger rund dynamischer. Cyberkriminelle scheuen weder Kosten noch Mühen, um ihre Methoden weiterzuentwickeln und Unternehmen immer einen Schritt voraus zu sein. Gleichzeitig werden die IT-Landschaften aufgrund von Remote Work sowie komplexen Cloudtechnologien immer unübersichtlicher. Es entstehen Silos, die sich über lokale und Cloudnetzwerke erstrecken. Für eine solche Umgebung reicht eine traditionelle Sicherheitsperipherie nicht mehr aus. Folglich steigt die Intransparenz. All das schränkt IT- und Sicherheitsteams massiv darin ein, den Überblick über die gesamte IT-Landschaft zu behalten und sie effektiv zu managen.

Als wäre diese schwer zu handhabende Komplexität allein nicht schon genug, hat sie zur Folge, dass sogenannte Blind Spots im Netzwerk entstehen. Diese treiben das Risiko, Bedrohungen und Sicherheitsverletzungen zu übersehen, spürbar in die Höhe. Denn da diese toten Winkel in der Regel so gut wie gar nicht einsehbar sind, können Angreifer darüber heimlich in das betroffene Unternehmensnetzwerk schlüpfen. Dabei können sie ganz unterschiedliche Formen annehmen – wie verschlüsselten Datenverkehr oder unautorisierte Anwendungen und Geräte (Schatten-IT). Die Folge: Etwa ein Drittel der Sicherheitsverletzungen bleiben laut einer aktuellen Studie unentdeckt im Netzwerk – genügend Zeit, sich auszubreiten und weitreichenden Schaden anzurichten.

Sichtbarkeit ist Grundvoraussetzung für Zero Trust

Um Herr über die Bedrohungslage zu werden und ihre On-Premises- und Cloudumgebung zu schützen, wenden immer mehr IT- und Security-Entscheider den Blick in Richtung Zero Trust. Bei 87 Prozent der Unternehmen beschäftigt sich der Vorstand mit dem Thema. Darüber hinaus gehen 96 Prozent der IT- und Security-Entscheider davon aus, dass das Modell in den kommenden Jahren sogar noch mehr an Bedeutung gewinnen wird. Das überrascht nicht. Schließlich bleiben innerhalb einer solchen Architektur Kontrolle und Zugriffsmanagement bei den Unternehmen selbst.

Allerdings wird bei der Planung einer Zero-Trust-Strategie häufig übersehen, dass für ihre Umsetzung lückenlose Sichtbarkeit über die gesamte IT-Landschaft gegeben sein muss. Das reine Access-Management reicht nicht aus. Jedoch hat ein beträchtlicher Anteil der Unternehmen nicht nur mit Blind Spots, sondern auch mit unzureichender Transparenz zu kämpfen. Lediglich 34 Prozent der IT- und Security-Entscheider geben an, dass sie über die für eine Zero-Trust-Architektur notwendige Sichtbarkeit verfügen. Der restliche Anteil weiß nur bedingt, was sich im Netzwerk abspielt, was sich auf Dauer zu einem Problem entwickeln kann.

Ohne diese Transparenz lassen sich die Zugriffsrichtlinien allerdings nicht umsetzen. Denn IT- und Security-Teams können die IT-Umgebung nur dann ganzheitlich schützen, wenn sie nachvollziehen können, wie sich Daten durch ihr Netzwerk bewegen, wo sich (sensible) Informationen befinden und wer beziehungsweise was Zugriff auf sie hat. So wird beispielsweise der Bürodrucker, der sich mit dem Netzwerk verbindet und auf Daten zugreift, häufig als potenzieller Angriffsvektor für Cyberkriminelle übersehen.

Deep Observability: Dem Netzwerk auf den Grund gehen

Angesichts des steigenden Risikos, Opfer eines Cyberangriffs zu werden, müssen IT- und Security-Entscheider dringend handeln. Ziel sollte es sein, die Komplexität mithilfe von tiefgehender Sichtbarkeit zu entzerren – und zwar über das gesamte Netzwerk hinweg, einschließlich der lokalen Hybrid- und Multicloud-Infrastruktur. Erst dann lassen sich gefährliche Schwachstellen in der Zero-Trust-Architektur beheben und das Konzept kann seine volle Wirkung erzielen. Ein Weg, um solch einen hohen Grad an Transparenz zu erreichen, bildet Deep Observability. Darin sind sich laut oben genannter Umfrage ausnahmslos alle IT- und Security-Entscheider einig.

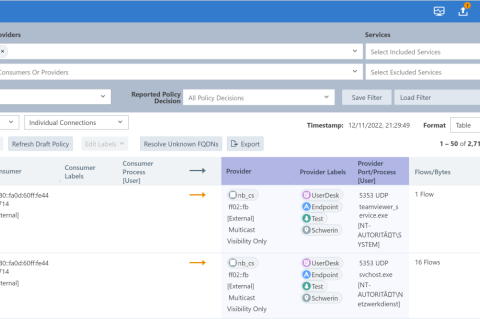

Eines der Hauptmerkmale von Deep Observability ist nämlich, dass es technisch weit über das herkömmliche metrik-, event-, log- und tracebasierte Monitoring hinausgeht. Beim letzterem werden IT-Teams auf akute Anomalien, Fehlermeldungen oder Sicherheitsverletzungen hingewiesen. Im Gegensatz dazu ermöglicht ein Deep-Observability-Werkzeug es ihnen, tiefer zu graben und die Ursache dieser Vorfälle zu identifizieren. So überwachen Network Packet Broker zum Beispiel sämtliche Network Traffic Access Points (TAPs) und überprüfen alle Datenpakete, die in und durch das Netzwerk fließen. Dafür legen sie entsprechende Duplikate an.

Der Datenverkehr liegt IT-Teams somit in gespiegelter Form vor, wodurch sie alle notwendigen Traffic-Informationen für weitere Maßnahmen erhalten. Sie können also handeln, bevor weitreichender Schaden entsteht. Da sich infolgedessen auch Blind Spots offenbaren, haben Angreifer keine Chance mehr, sich in nicht einsehbaren Netzwerkecken zu verstecken. Es entsteht also eine lückenlose Einsicht in die gesamte IT-Landschaft, auf der sich eine Zero-Trust-Architektur ideal aufbauen lässt.

Fazit

Durch die Verteilung von Zugriffsberechtigungen sorgt das Zero-Trust-Modell selbst in höchst komplexen IT-Umgebungen für Sicherheit und Kontrolle. Allerdings geht das Prinzip weit über das reine Access-Management hinaus. Damit es überhaupt funktionieren kann, müssen IT- und Sicherheitsteams wissen, wie sich der Datenstrom im Netzwerk verhält, wo sensible Informationen abliegen und welche Mitarbeiter, Anwendungen und Geräte darauf zugreifen.Die Mehrheit der Entscheider hat aber mit zahlreichen Herausforderungen wie Blind Spots zu kämpfen. Bevor diese sich also dem Zero-Trust-Modell zuwenden und eine entsprechende Architektur implementieren können, müssen sie die Netzwerksichtbarkeit steigern. Mithilfe einer Deep-Observability-Software bringen sie Licht ins Dunkel und decken beliebte Verstecke auf. Somit sorgt sie nicht nur für Transparenz bis auf Netzwerkebene, sondern schafft auch das notwendige Zero-Trust-Fundament.

ln/Ali Moniri, Senior Sales Engineer bei Gigamon