KI-Infrastrukuren aus der Cloud

Kein IT-Verantwortlicher kommt aktuell um die Frage herum, wie und ob das Unternehmen auf den KI-Zug aufspringen kann. Gegenwärtig konzentriert sich die Fähigkeit, selbst KI-Anwendungen auf die Beine zu stellen, auf Konzerne, Forschungsinstitute und üppig finanzierte Startups, da eine entsprechende Infrastruktur sehr teuer ist. Mit KI-Clouds, auch oft als GPU-Clouds bezeichnet, kommt ein Gegentrend auf. Unser Fachartikel erklärt, was es mit diesen Angeboten auf sich hat, die heute noch oft in den Kinderschuhen stecken. Wie funktionieren KI-Clouds und worauf kommt es an?

Auch wenn KI aktuell in aller Munde zu sein scheint, stehen viele deutsche Unternehmen in dieser Disziplin erst am Anfang. Laut Bitkom nutzen aktuell 15 Prozent aller Unternehmen in Deutschland KI, weitere 28 Prozent planen oder diskutieren den Einsatz von KI. Zugleich starten finanzkräftige Großunternehmen teilweise spektakuläre KI-Programme. Im Startup-Umfeld vermeldete Aleph Alpha eine 500 Millionen Euro starke Finanzspritze zum Aufbau eines eigenen Angebots. Beschränkt sich das Thema KI auf einige wenige Unternehmen, die das nötige Kleingeld haben, sich kapitalintensive Infrastrukturen aufzubauen – und der Mittelstand schaut in die Röhre?

KI-Ressourcen aus der Cloud versprechen, diese Herausforderungen zu lösen und Unternehmen bei der Umsetzung von KI-Anwendungsfällen zu unterstützen. Mit speziellen KI-Clouds, auch oft als GPU-Clouds bezeichnet, kommt nun ein Gegentrend auf, der die "Demokratisierung" von KI verspricht – ganz im Sinne von "KI/ML-as-a-Service". Hier arbeiten nicht nur die großen Cloud-Player wie AWS, GCP und Azure an entsprechenden Diensten, sondern auch kleinere, spezialisierte Anbieter. Was bieten diese Dienste, die heute noch oft in den Kinderschuhen stecken? Wie funktionieren KI-Clouds und worauf kommt es an? Sind GPU-Clouds eine echte Alternative zum komplexen On-Prem-basierten KI-System oder eher fauler Zauber in Form von großspurigen Marketingversprechen?

Was die Cloud-Platzhirsche in Sachen KI bieten

Das KI-Fortschrittszentrum "Lernende Systeme und Kognitive Robotik" der Fraunhofer-Gesellschaft hat in seiner Studie "Cloudbasierte KI-Plattformen" die cloudbasierten KI-Plattformen der vier größten Public-Cloud-Serviceprovider Amazon Web Services, Google Cloud Platform, IBM Cloud sowie Microsoft Azure evaluiert. Die Studie gibt einleitend zu bedenken, dass KI-Einführungen oft bereits in der Anfangsphase scheitern, da das nötige Know-how oder anderweitige Ressourcen nicht ausreichend zur Verfügung stehen.

Verschiedene Anbieter haben dieses Problem jedoch erkannt und bieten Wege, um die Umsetzung von KI-Anwendungsfällen zu unterstützen. Diese versprechen gute Ergebnisse, ohne unbedingt tiefgehendes Wissen im Bereich des maschinellen Lernens zu erfordern. Die Grundidee ist laut der Studie, gebräuchliche Methoden und Werkzeuge eines KI-Projekts sowie und KI-Workflows automatisiert in der Cloud bereitzustellen. Dieser Ansatz soll einerseits die Anschaffung teurer Hardware überflüssig und anderseits die Nutzung der Plattform durch Fachfremde ermöglichen.

In der Fraunhofer-Studie sind cloudbasierte KI-Plattformen definiert als Machine-Learning-as-a-Service (MLaaS)-Werkzeuge, die Datenspeicher, Rechenkapazität, Algorithmen, Schnittstellen et cetera über die Cloud bereitstellen. Unternehmen, die auf diese Dienste zurückgreifen, müssen weder lokal Software installieren noch Server oder Storage-Ressourcen betreiben. Die Evaluierung erfolgte anhand von Funktionsumfang, technischen und geschäftlichen Kriterien. Eine der Anforderungen an die evaluierten Dienste war deren Eignung, die KI-Ressourcen einer breiteren Anwendergruppe zugänglich zu machen, die mitunter nur über Grundlagenkenntnisse des maschinellen Lernens oder Programmierens verfügt.

Grafische Oberflächen und hochgradige Automatisierung sind laut Studie hier hilfreich. Als eines der wichtigen technischen Kriterien ist die Skalierbarkeit der Hardware aufgeführt, wenn in einem KI-Projekt mehr Datenpunkte oder mehr eingehende Merkmale erforderlich werden. Ist mehr Rechenleistung nötig, muss der Dienst skalierbar sein. Dies kann der Fall sein, wenn das maschinelle Lernen auch für unstrukturierte Daten statt nur für strukturierte Daten zum Einsatz kommen soll oder wenn sich die Anzahl der zu verarbeitenden Predict-Aufrufe erhöht. Hierbei ist entscheidend, wie einfach, schnell und kostengünstig die Skalierbarkeit ist.

Vier große Anwendungsfälle

Die Studie untersuchte zudem vier KI-Use-Cases aus den größten in der Wirtschaft gängigen Anwendungsgebieten des maschinellen Lernens: strukturierte Daten, Sprachverarbeitung (Natural Language Processing), Bilderkennung und Zeitreihenanalyse. Hier kamen bereits Unterschiede und Schwierigkeiten zu Tage, etwa bei der Textklassifikation. Während Microsoft Azure derzeit überhaupt keine Easy-to-use-Funktionen zum Training eigener NER-Modelle (Named Entity Recognition) anbietet, verlangen die anderen Plattformen ein proprietäres Eingangsformat der Trainings- und Testdaten, das einiges an manueller Vorverarbeitung und Konvertierung erfordert.

Bei der Studie wurde deutlich, dass die Anbieter viele Ressourcen in die Weiterentwicklung ihrer Angebote investieren, um Mitbewerbern im heiß umkämpften MLaaS-Markt Anteile abzujagen, woraus sowohl Vor- als auch Nachteile resultieren. Einerseits bieten sich vielfältige Möglichkeiten, eigene Visionen umzusetzen, andererseits erschwert die Vielzahl der Dienste, Fachbegriffe und Teilbereichen gerade für KI-Neulinge den Einstieg. Für die Zukunft rechnet das KI-Fortschrittzentrum mit konsolidierten KI-Plattformen, die es Einsteigern noch einfacher machen, Ergebnisse mittels maschinellen Lernens zu erzielen und auch zu interpretieren.

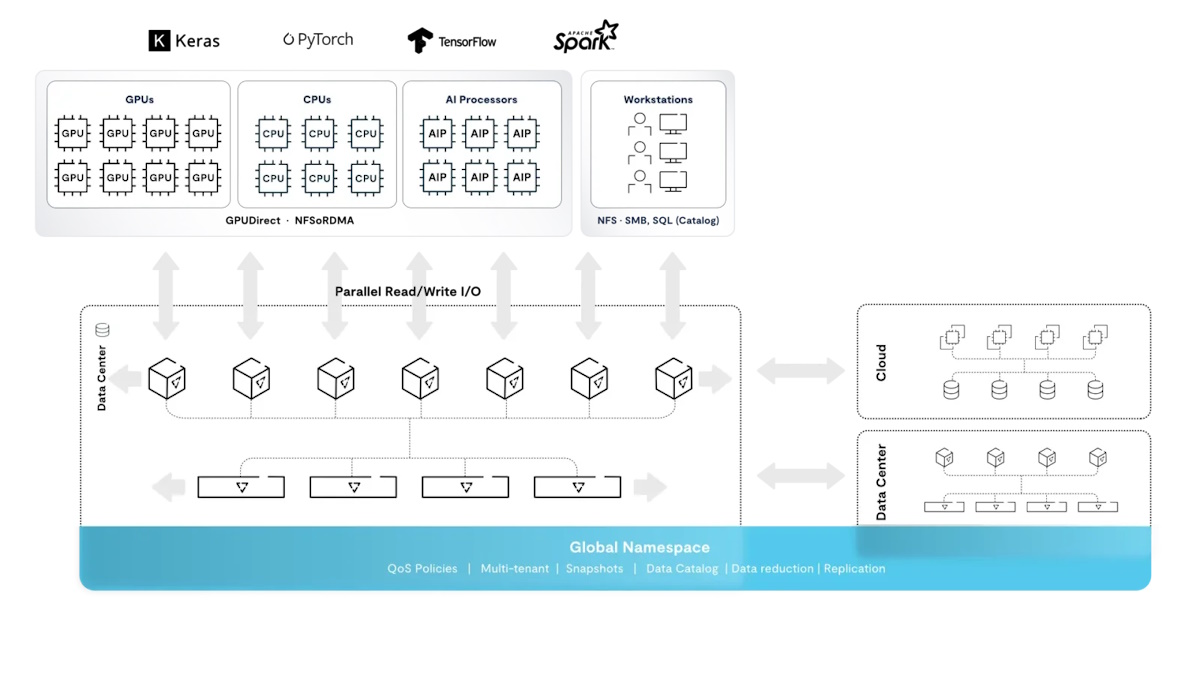

So gibt es bereits neben cloudbasierten KI-Plattformen der großen Public-Cloud-Betreiber auch zunehmend kleine, spezialisierte KI-Cloud-Serviceprovider wie CoreWeave oder Lambda Labs. Diese setzen auf eine auf der DASE-Architektur (Disaggregated Shared-Everything) basierende Datenplattform, die in jeder Größenordnung vollparallel ist und die für KI-Supercomputer erforderlichen Optimierungen wie RDMA I/O und GPUDirect Services bietet.

Spezialisierte KI-Cloud-Serviceprovider

CoreWeave, ein spezialisierter Cloud-Provider, der viele der weltweit führenden generativen KI-Projekte vorantreibt, verfolgt ein anspruchsvolles Ziel. Das Unternehmen ist gerade dabei, eine globale NVIDIA-basierte Cloud für Accelerated Computing zur Bereitstellung, Verwaltung und Sicherung von Hunderten von PBytes an Daten für generative KI, High Performance Computing (HPC) und visuelle Effekte (VFX) aufzubauen. Die Plattform verfügt über die notwendige Skalierung, Leistung und mandantenfähigen Enterprise-AI-Cloud-Fähigkeiten, die erforderlich sind, um die massiven KI-, LLM-Trainings- und Inferenz-Anwendungen zu betreiben.

Ein weiteres Beispiel für "KI aus der Cloud" ist die On-Demand-GPU-Cloud von Lambda, die GPU-Setups für LLM-Aufgaben bietet. Das Produktportfolio umfasst ein Hyperscale-KI-Cloud-Angebot und ein Rechenzentrumsportfolio mit NVIDIA-Grafikprozessoren, darunter NVIDIA-H100-Tensor-Core-Grafikprozessor-Cluster, die für einen Leistungs- und Skalierungssprung in der Größenordnung von KI-Workloads ausgelegt sind. Das Ergebnis ist ein Lösungs-Stack und eine Cloud-Betriebsumgebung, die sich bis in das Rechenzentrum der Nutzer ausdehnen lässt. Lambda verfolgt dabei einen einzigartigen Ansatz für den Aufbau global verteilter Namespaces für Dateien, Objekte und Tabellen. Dieser neue Ansatz für die globale Datenverwaltung hebt den Kompromiss zwischen strikter globaler Konsistenz und schnellem Zugriff am Edge auf, da nun beides möglich ist.

Fokus auf GPUs und Datenplattformen

GPUs und Datenplattformen werden weiterhin für den Erfolg von KI-Initiativen entscheidend sein. Die Auswahl der richtigen GPU-Serverhardware ist jedoch an sich schon eine Herausforderung. Eine marktorientierte Cloud-KI-Plattform sollte darauf konzentriert sein, die Kosten und Reibungsverluste rechenintensiver Workloads zu reduzieren und es jedem Unternehmen ermöglichen, Container-Instanzen mit erschwinglichen, leistungsstarken GPUs in Sekundenschnelle aufzusetzen. Eine globale GPU-Liquidität sorgt dabei für eine schnelle horizontale Skalierung auf Tausende von GPUs.

Eine Bewertungsfunktion kann die Hardwareleistung für typische Deep-Learning-Aufgaben vorhersagen. Dies hilft Unternehmen bei der Automatisierung und Standardisierung der Bewertung und des Rankings von unzähligen Hardwareplattformen aus Dutzenden von Rechenzentren und Hunderten von Anbietern. Jeder Cloudprovider hat zudem seine eigene Schnittstelle, Namenskonvention und Preissysteme, die einen direkten Vergleich erschweren. Die Bindung an einen bestimmten Anbieter führt zu höheren Preisen, sobald sich Unternehmen für einen einzigen Anbieter entscheiden. Eine automatisierte Suche ermöglicht einen fairen Vergleich aller Arten von Anbietern – von preisgünstigen Anbietern mit Consumer-GPUs bis hin zum Tier-4-Rechenzentrum. Dies erlaubt es Nutzern, schnell die besten Optionen und Angebote für Compute-Services entsprechend ihren spezifischen Anforderungen zu finden.

Heute besteht der Großteil der allgemeinen Rechenleistung der Welt aus Grafikprozessoren, die für das Mining von Kryptowährungen oder für Spiele verwendet werden. Aufgrund neuer ASICs (Application-specific Integrated Circuits) und anderer Verschiebungen im Ökosystem, die zu sinkenden Gewinnen führen, benötigen diese GPUs neue Verwendungszwecke. Ein sinnvoller Ansatz ist es daher, den Prozess der Vermietung von Maschinen zu vereinfachen und es jedem Akteur zu ermöglichen, zum KI-Cloud-Anbieter zu werden, was zu deutlich niedrigeren Preisen führt, damit mehr Unternehmen und letztlich Menschen von den KI-generierten Erkenntnissen profitieren zu können.

Fazit

Zusammenfassend lässt sich sagen, dass KI aus der Cloud insbesondere durch die neuen spezialisierten KI-Cloud-Anbieter eine sinnvolle Alternative zu On-Prem-basierten KI-Systemen darstellt und sogar den Einstieg in KI erleichtern kann, während eventuell im Unternehmen noch das entsprechende Know-how oder die entsprechende Infrastruktur aufgebaut wird. Im späteren Verlauf kann dann abhängig vom konkreten Bedarf immer noch auf einen lokalen Ansatz umgestellt oder ein durch neue Technologien möglich gewordenes hybrides Modell gefahren werden. Das Wichtigste dabei ist aber, dass Unternehmen jetzt den ersten Schritt zur Nutzung von KI machen, denn die Konkurrenz schläft nicht.

ln/Sven Breuner, Field CTO International bei VAST Data