Die Private Cloud und das Unternehmensnetzwerk

Die Cloud ist in der Realität angekommen - IT-Profis müssen Konzepte für ihre Nutzung vorlegen. Das bevorzugte Modell ist dabei die Private Cloud, da hier die Hoheit über Anwendungen und Daten im Unternehmen verbleibt. Zentrale Ressource für die Cloud ist das Unternehmensnetzwerk. Der Fachartikel umreißt die Anforderungen an das zugrundeliegende Netzwerk, beschreibt die Vorteile einer intelligenten Infrastruktur und wie sich diese - auch auf vorhandene Umgebungen - effizient aufbauen lässt.

Für den Erfolg von mittelständischen Unternehmen ist der effektive IT-Einsatz von entscheidender Bedeutung. Insbesondere die optimale Ausnutzung der Rechenkapazitäten ist hier ein Thema, weshalb das Thema Cloud Computing in diesem Umfeld immer interessanter wird. Infrastrukturen und Software werden dabei nach Bedarf als Service bezogen und abgerechnet. Besonders beliebt sind sogenannte Private Clouds, da sich diese individueller auf die Anforderungen anpassen lassen.

Außerdem bestehen häufig noch Bedenken, firmeninterne Daten einem Cloud-Service-Provider anzuvertrauen oder zugänglich zu machen. Viele Mittelständler wollen daher zunächst eigene Erfahrungen mit Cloud Computing sammeln und zwar vorzugsweise im eigenen Haus. Bewährt sich diese Technologie, lässt sich das Konzept ausbauen, etwa in Richtung einer Mischung aus Diensten, die das eigene Rechenzentrum bereitstellt und standardisierten Public-Cloud-Services wie SaaS (Software as a Service) oder IaaS (Infrastructure as a Service).

Allerdings lassen sich Cloud-Services nur dann sinnvoll nutzen, wenn auch die zugrundeliegende Infrastruktur der IT stimmt – oder entsprechend umgestellt und den vielseitigen Möglichkeiten angepasst wird. Dem Unternehmensnetzwerk, das für einen effizienten und schnellen Zugriff auf Daten und Anwendungen verantwortlich ist, kommt dabei zentrale Bedeutung zu. Insbesondere die Verbindungen zwischen einzelnen Rechenzentren müssen ebenso dynamisch und flexibel arbeiten wie die Rechenzentren selbst, um das Potenzial der Private Cloud in vollem Umfang auszuschöpfen.

Hohe Bandbreiten belasten das Netzwerk

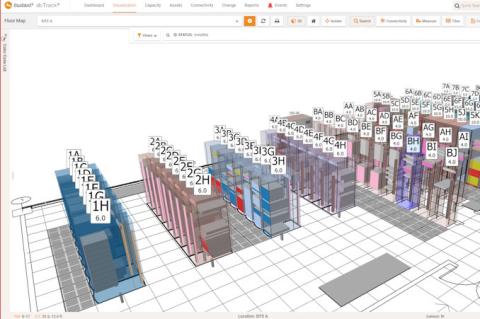

Aufgrund der ausschließlich intern gelagerten Anwendungen verlangt die Private Cloud dem Unternehmensnetzwerk am meisten ab. Eine wesentliche Anforderung ist, dass nicht zuletzt aufgrund der zunehmenden Virtualisierung und Konsolidierung unternehmensweiter IT-Systeme die Bandbreitenanforderungen ständig steigen. Sollen zum Beispiel georedundante Rechenzentren angebunden und synchronisiert werden, gilt es, große Datenmengen im WAN sicher und vor allem latenzarm zu übertragen. Ebenso ist es erforderlich, virtuelle Maschinen über die Grenzen von lokalen Rechenzentren hinweg nutzen zu können, da auch kleinere Unternehmen zunehmend globaler agieren und Mitarbeitern weltweit Informationen und Anwendungen aus dem Unternehmensnetzwerk zur Verfügung stellen wollen.

Ein weiteres Stichwort sind sogenannte vApps (virtual Appliance, Anwendungen, die eine oder mehrere virtuelle Maschinen, die gemeinsam einen Dienst abbilden, zusammenfassen). Damit diese flexibel auf mehrere virtuelle Maschinen zugreifen können, müssen theoretisch alle beteiligten physischen Server zu jeder Zeit die volle Input/Output-Leistung zur Verfügung stellen können. Einzelne Server-Blades unterstützen heute schon eine I/O-Leistung von 10 GBit/s. Bei acht Server-Blades in einem Blade-Center summiert sich diese Leistung auf 80 GBit/s – eine echte Herausforderung für das Netzwerk.

Netzwerk richtig optimieren

Erforderlich ist angesichts solcher Anforderungen eine grundlegende Modernisierung der Netzwerkinfrastruktur. Der typische Zugang des Anwenders zum Cloud Computing erfolgt in der Regel über ein VPN oder eine normale Internetverbindung. Auch private MPLS/VPLS-Netzwerke bieten Cloud-Konnektivität. Darüber hinaus gibt es auch die direkte Verbindung von Rechenzentren untereinander. In jedem Fall sind diese Verbindungen das Herz des Cloud Computing und erfordern eine hohe Funktionssicherheit, Skalierbarkeit und Mobilität.

Eine Optimierung des Netzwerks sollte daher hier ansetzen und ist angesichts neuer technologischer Entwicklungen möglich: Beim Coherent Optical Processing wird die Netzwerkkapazität erhöht, um den umfangreichen Datenverkehr zwischen Rechenzentren abzuwickeln. Das Optical Transport Network (OTN) wiederum verstärkt Signalreichweiten und die Zahl der benötigten Netzwerkelemente und trägt damit zu einer effizienteren Bandbreitennutzung bei. Intelligente Control-Plane-Lösungen bieten in Ergänzung dazu die Möglichkeit, zum Beispiel in Spitzenzeiten auf Veränderungen des Netzwerks zu reagieren und täglich wiederkehrende Vorgänge ohne manuelle Steuerung auszuführen. Mithilfe der Control-Plane-Technologie kann das Netzwerk automatisch auf unerwartete Situationen reagieren. Nach einem Netzwerkausfall kann sich das Netzwerk meist ohne manuelles Eingreifen selbst wiederherstellen.

Seite 1 von 2 Nächste Seite>>

Eugen Gebhard, Managing Director Central Europe bei Ciena/ln