So werden Rechenzentren den Ansprüchen gerecht

Die digitale Transformation hat sich in den vergangenen Jahren erheblich beschleunigt. Die Bedeutung der IT-Infrastruktur hat dadurch enorm an Gewicht gewonnen – bis hin zu einer Abhängigkeit, die kritische Teile der öffentlichen Versorgung und der Wirtschaft betrifft. Neben Fragen der Rechen- und Speicherkapazität, der verfügbaren Bandbreite sowie der Cybersecurity sind durch den höheren Stellenwert der IT weitere Anforderungen in den Vordergrund gerückt. Der Fachartikel gibt einen Überblick, was RZ-Betreiber bei der regelmäßigen Modernisierung im Auge behalten sollten.

Behördengänge im Internet, Mobile Banking, KI-basierte Produktionssteuerung und datenbasierende Geschäftsmodelle – die Digitalisierung hat sich auf breiter Front durchgesetzt und durchdringt immer neue Bereiche von Wirtschaft und Gesellschaft. Was in Großunternehmen mit Cloud Computing und Industrie 4.0 begann, zählt heute bei vielen kleinen und mittleren Unternehmen bereits zum Standard. Auch ein großer Teil der Konsumenten geht mit Self-Service-Portalen und digitalen Assistenzsystemen inzwischen wie selbstverständlich um.

Der verstärkte Einsatz von IT in immer mehr Bereichen und die wachsende Anzahl von Anwendungsfällen für IT in Alltag und Berufsleben, in Produktions- und Dienstleistungsbranchen, führt auch zu umfassenderen Anforderungen an die Infrastruktur und deren Anbieter, wie etwa Rechenzentrumsbetreiber. Im Folgenden beleuchten wir deshalb die vier wichtigsten Felder, die es bei der kontinuierlichen Modernisierung von Data Centern zu beachten gilt.

Genügend Bandbreite bereitstellen

Eine Folge der anfangs skizzierten Entwicklungen lässt sich am weltweit größten Internet-Austauschknoten DE-CIX in Frankfurt/Main ablesen: Dessen Peak-Traffic stieg im ersten Pandemie-Jahr von 6 auf 10 TBit/s, 2021 wurden sogar schon fast 11 TBit/s erreicht. Aber nicht nur die Spitzen erlangten Höchstwerte. Mit einem Gesamtdurchsatz von 38 EByte im Jahr 2021, nahm der Datenverkehr um rund 20 Prozent zum Vorjahr zu. Dieser Wert wurde von vorgelagerten Verteilerknoten sogar übertroffen. So konnten der DE-CIX Hamburg, DE-CIX Düsseldorf und DE-CIX München sogar ein Plus von 40 bis 70 Prozent in diesem Zeitraum verzeichnen. Das massive Wachstum der dort angeschlossenen Kundenbandbreite – zwischen 40 und 160 Prozent – lässt erahnen, dass sich dieser Trend fortsetzen wird.

Für Rechenzentren heißt dies, die eigene Anbindung und die interne Bandbreite regelmäßig der Entwicklung anzupassen. So setzen hierzulande immer mehr Data Center auf Netzwerktechnik der 800G-Klasse, also für 800-GBit-Ethernet. Am Horizont scheint bereits der Wechsel zur nächsten Stufe 1600G (1,6 TBit/s) auf.

Moderne Technologien nutzen

Darüber hinaus muss die Infrastruktur im Rechenzentrum auch auf neue technologische Anforderungen der Kunden reagieren. Der Einsatz von Quanten-Computing, die verstärkte Nutzung von KI auf Basis neuronaler Netze, die Portabilität und Interoperabilität im Umfeld von Multicloud-Konzepten, der zunehmende Einsatz von DevOps und Microservices, beispielsweise zum Aufbau von Blockchains und darin eingebettete "Smart Contracts", Trends wie Edge Computing oder die Zusammenlegung von Berechnung, Speicherung und Vernetzung in einem einzigen System (Hyperkonvergenz) verlangen nach geeigneten Strukturen und Architekturen in Rechenzentren. Dies sind nur einige der relevanten Technologien, weitere können jederzeit hinzutreten. Hier gilt es, die aktuellen Trends im Auge zu behalten und rechtzeitig zu reagieren.

Energie- und Kosteneffizienz beachten

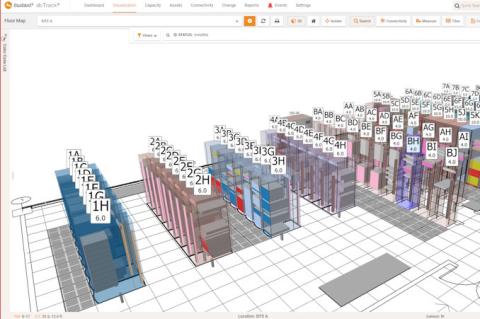

Immer leistungsfähigere Hardware für größere Bandbreiten- und Datenspeicher-Kapazitäten sowie die Implementierung weiterer Anwendungen und Services werfen ein neues Problem auf: Wie lassen sich diese Ressourcen effizient managen und betreiben? Hier sind zum einen moderne Managementkonzepte und -strategien gefragt. Hohe Flexibilität und eine enge Integration von Management-, Überwachungs- und Steuerungsfunktionen stehen dabei aktuell im Fokus. Virtualisierte beziehungsweise softwarebasierte Strukturen haben sich dabei bewährt. So hat sich das Data Center Infrastructure Management (DCIM) zum Software Defined Data Center (SDDC) weiterentwickelt, begleitet von Software-defined Networks (SDN) beziehungsweise Software-defined Wide Area Networks (SDWAN).

Auf diese Weise gelingt es, Netzwerkstrukturen, -funktionen und -services per Softwarekonfiguration schnell und mit überschaubarem Aufwand an neue Erfordernisse anzupassen. Auch lassen sich neue, zusätzliche Ressourcen sehr einfach hinzufügen und dem Nutzer bereitstellen. Die damit verbundenen Skaleneffekte ermöglichen es, die wachsende, komplexer werdende Infrastruktur zu beherrschen, ohne im gleichen Maße Fachpersonal aufstocken zu müssen.

Zum anderen spielt die Energieeffizienz eine immer größere Rolle. Die schnell steigenden Energiepreise stellen einen erheblichen Kostenfaktor dar. Stromsparende Hardware und energieoptimierte Steuerungsprozesse, ebenso intelligente Klimatisierungskonzepte, die Abwärme als Ressource und nicht als "Abfall" behandeln, können sich schnell auszahlen. Die neugefassten Klimapläne der deutschen Bundesregierung zum früheren Erreichen der CO2-Neutralität und die kommende Taxonomie der EU sind zusätzliche Faktoren, die schnell an Bedeutung gewinnen.

Der CO2-Fußabdruck eines Rechenzentrums wird insbesondere im gewerblichen Umfeld als Entscheidungskriterium größeres Gewicht einnehmen, wenn Unternehmen in ihrer eigenen Klimabilanz auch Zulieferer und Dienstleister berücksichtigen. Im Rahmen der Taxonomie wird die Frage der Klimafreundlichkeit eines Unternehmens auf die Finanzierungskosten durchschlagen und damit ebenfalls auf Wirtschaftlichkeit und Wettbewerbsfähigkeit.

Das A und O: Datensicherheit und Resilienz

Angesichts der steigenden Abhängigkeit von Wirtschaft und Gesellschaft von IT-Infrastrukturen sind allerdings Sicherheit und Zuverlässigkeit mit Abstand die wichtigsten Anforderungen. Traditionell steht Cybersecurity im Licht der Aufmerksamkeit. Doch für Rechenzentrumsbetreiber kommen noch eine ganze Reihe weiterer Aspekte hinzu, die ebenfalls auf einen sicheren Betrieb und eine verlässliche Bereitstellung der Dienstleistungen einzahlen.

Das haben auch Politik und Aufsichtsbehörden erkannt, die mit gesetzlichen Auflagen und strengeren Vorschriften die Anforderungen an IT-Infrastrukturen verschärfen. Besonders betrifft dies Unternehmen der kritischen Infrastruktur, kurz KRITIS. Dabei handelt es sich um Organisationen oder Einrichtungen mit wichtiger Bedeutung für das staatliche Gemeinwesen, bei deren Ausfall oder Beeinträchtigung nachhaltig wirkende Versorgungsengpässe, erhebliche Störungen der öffentlichen Sicherheit oder andere dramatische Folgen eintreten würden.

Bei der Definition von KRITIS umfasst der Kreis der Betroffenen inzwischen rund 1850 Unternehmen, die sich auf zehn Wirtschaftssektoren und eine Sonderkategorie verteilen: Informationstechnik und Telekommunikation, Gesundheit, Energie, Wasser, Ernährung, Finanz- und Versicherungswesen, Transport und Verkehr, Siedlungsabfall-Entsorgung, Staat und Verwaltung, Medien und Kultur und Unternehmen im besonderen öffentlichen Interesse.

Wichtig ist, dass nicht nur die Kunden von Rechenzentren unter die KRITIS-Definition fallen, sondern auch Provider und Data Center selbst zur kritischen Infrastruktur zählen, wenn sie gewisse Schwellenwerte überschreiten. So sind beispielsweise Zugangs- und Übertragungsprovider betroffen, die mindestens 100.000 Teilnehmer versorgen. Damit liegt beispielsweise die Grenze für DNS-Server und Top-Level-Domain-Registrare bei 250.000 Domänen. Ferner gelten DNS-Resolver als kritisch, die mehr als 100.000 Vertragspartner haben. Internet-Austauschknoten zählen ab 100 angeschlossenen autonomen Systemen in den Betroffenenkreis.

Was viele nicht wissen ist, dass am 1. Januar 2022 die Regularien verschärft wurden. Um zwei Beispiele zu nennen: Seit diesem Zeitpunkt gelten Rechenzentren bereits ab 3,5 MW als kritische Infrastruktur. Davor lag die Grenze bei 5 MW. Auch bei Serverfarmen wurde der Schwellenwert von bisher 25.000 auf 10.000 physische beziehungsweise 15.000 virtuelle Instanzen herabgesetzt.

Gesetzliche Grundlagen von KRITIS

In Deutschland sind zentrale Anforderungen in der KRITIS-Verordnung (KritisV) 1.5 niedergelegt. Weitere Vorgaben finden sich beispielsweise im BSI-Gesetz (BSIG), das Regelungen in Bezug auf das Bundesamt für Sicherheit in der Informationstechnik (BSI) enthält. So verpflichtet beispielsweise §8a die Unternehmen dazu, "angemessene organisatorische und technische Vorkehrungen zur Vermeidung von Störungen der Verfügbarkeit, Integrität, Authentizität und Vertraulichkeit ihrer informationstechnischen Systeme, Komponenten oder Prozesse zu treffen, die für die Funktionsfähigkeit der von ihnen betriebenen Kritischen Infrastrukturen maßgeblich sind".

Kurz gesagt: Alle Betreiber von IT-Infrastruktur müssen diese auf dem "Stand der Technik" halten. Im Fall der KRITIS-Anforderungen stellt das BSI darüber hinaus auf branchenspezifische Sicherheitsstandards (B3S) ab, die in der Regel von Branchenverbänden definiert werden. KRITIS-Unternehmen müssen sich alle zwei Jahre nach diesen Standards zertifizieren lassen.

Wie die Technik selbst ist auch der gesetzliche Rahmen im steten Wandel begriffen – weitere Verschärfungen sind bereits in Arbeit. In Deutschland wird gerade an der KRITIS-Verordnung 2.0 gefeilt, auf EU-Ebene stehen die Direktiven RCE und NIS2 in den Startlöchern. Mit der Direktive "Resilience of Critical Entities" (RCE) sollen Organisationen, die kritische Dienste in der Europäischen Union erbringen, im Hinblick auf ihre Widerstandsfähigkeit und die möglichen Risiken reguliert und von den nationalen Regierungen beaufsichtigt werden. Ähnlich wie mit der deutschen KRITIS-Verordnung ist es das Ziel von RCE, die Ausfallsicherheit von kritischen Diensten in der gesamten EU zu stärken.

Die "Directive on Security of Network and Information Systems" (EU NIS2) zielt auf die Regulierung der Informationssicherheit von kritischen Betreibern ab, um die Auswirkungen von Cyberangriffen und Störungen auf IT-Systeme und Netzwerke zu minimieren. Sie verlangt von den Betreibern dazu eine Reihe von Maßnahmen, wie die Festlegung von Policies und Governance, Einführung von Incident- und Continuity-Management, IT-Sicherheit in der Supply Chain, IT-Audits und Tests, sowie die Nutzung von Kryptographie.

Auswirkungen der KRITIS-Verordnung

Die Anforderungen der KRITIS-Verordnung erstreckt sich auf unterschiedliche Bereiche. Dazu zählt unter anderem die bauliche und physische Sicherheit. Elektrizitätsversorgung, Temperatur- und Feuchtigkeitskontrolle, Telekommunikation und Internetverbindung müssen abgesichert sein. Darüber hinaus sind die Betreiber verpflichtet, die entsprechenden Systeme nicht nur zu überwachen und regelmäßig zu warten, sondern auch zu testen, um die Funktionsfähigkeit jederzeit zu gewährleisten. Dazu sind auch automatische Ausfallsicherungen und anderen Redundanzen zu integrieren.

Gebäude und Räumlichkeiten, in denen sensible oder kritische Informationen gelagert, verarbeitet oder durchgeleitet werden, müssen physisch solide gebaut und mit angemessenen Sicherheitsmaßnahmen, beispielsweise einer Zutrittskontrolle, versehen sein. Aber auch Risiken aus Naturereignissen und menschengemachten Gefahren sind zu beachten: Feuer, Wasser, Erdbeben, Explosionen und zivile Unruhen sind nur einige Beispiele. Nicht zuletzt sind hier auch Konsequenzen aus dem Klimawandel zu ziehen: Mangel an Löschwasser und erhöhte Waldbrandgefahr wegen Trockenheit, Überflutungen wie im Ahrtal sowie ein stärkeres Risiko von Erdrutschen bei Starkregen. Deshalb wurden zuletzt auch die Anforderungen an die Standortwahl verschärft, auch in Hinblick auf redundante Anlagen, die im Fall des Falles den Betrieb übernehmen sollen oder dem Disaster Recovery dienen. Der Anforderungskatalog ist höchst komplex.

Um den Überblick zu bewahren und allen Erfordernissen gerecht zu werden, kann es helfen, externe Experten hinzuzuziehen. Derartige Spezialisten gleichen dann die Passgenauigkeit der gültigen Anforderungskataloge mit der vorhandenen baulichen und physischen Sicherheit der IT-Infrastruktur ab und entwickeln daraus Maßnahmenlisten. Hierbei sollte der Fokus auf der Gewährleistung des geforderten Sicherheitsniveaus und dem zu erfüllenden Schutzbedarf der IT liegen. Neben den technischen Rahmenbedingungen gilt es hierbei auch organisatorische Determinanten zu berücksichtigen.

Designkonzepte einhalten

Ein erheblicher Teil der Anforderungen lässt sich erfüllen, wenn von Anfang an grundsätzliche Designkonzepte eingehalten werden, insbesondere Redundanz, Modularität und Skalierbarkeit. Auch zu diesen Prinzipien stellt das BSI eine eigene Veröffentlichung bereit, die anschaulich die verschiedenen Aspekte und Ausprägungen darstellen. Ohne Redundanz, Modularität und Skalierbarkeit sind hoch- und höchstverfügbare Systeme nicht denkbar. Zugleich sind diese Prinzipien eng miteinander verknüpft.

Redundanz beschreibt das Vorhalten von zusätzlichen Systemen über den eigentlichen Bedarf hinaus, die bei Ausfall oder Störung als Ersatz dienen können. Im einfachsten Fall wird beispielsweise eine zweite USV installiert. Eine besondere Form ist Redundanz durch Diversität. Damit ist der Einsatz von Systemen gemeint, die funktional gleichwertig, aber in der Regel von unterschiedlichen Herstellern sind, zumindest aber Produkte unterschiedlicher Chargen oder verschiedener Modellserien. So lassen sich Serien- und Konstruktionsfehler vorbeugen.

Modularität bedeutet in diesem Kontext die Aufteilung von Leistung oder Kapazitäten auf mehrere, kleinere Einheiten. Also statt einer USV mit 100 kVA der Einsatz von vier USVs mit je 25 kVA. Kommt es zu einer Störung, fällt die Funktion nicht komplett aus, sondern nur in einem Teil der Anlage. Redundanz lässt sich in diesem Fall mit einem zusätzlichen 25-kVA-Modul herstellen, das wesentlich günstiger ist als eine weitere 100-kVA-Anlage. Ebenso ist eine Diversifikation über die vier Module einfacher zu bewerkstelligen. Auch der Ersatz defekter Systeme ist dann wesentlich flexibler zu realisieren.

Skalierbarkeit drückt die Fähigkeit aus, zusätzliche Einheiten hinzuzufügen, ohne Anlage grundsätzlich neu zu planen oder aufwändig umbauen zu müssen. Je höher die Skalierbarkeit, umso einfacher lassen sich zusätzliche Ressourcen, also Rechenpower und Speicherplatz, Bandbreite und alle weiteren Systeme wie USV, Klimatisierung und Management hinzufügen.

Fazit

Das Spektrum an Beweggründen, ein Rechenzentrum zu erweitern, zu modernisieren oder zu optimieren, ist vielfältig. Angesichts des ständig wachsenden Kreises der IT-Anwender, die unter den KRITIS-Begriff fallen, und der ständig wachsenden Sicherheitsanforderungen, ist es für die Betreiber von Rechenzentren ein Muss, sich bei anstehenden Veränderungen auch mit den KRITIS-Bedingungen auseinanderzusetzen. Für die erfolgreiche Umsetzung des Transformationsprojekts gilt jedoch: Für eine nahtlose Integration der Sicherheitsmaßnahmen sind die Erfordernisse bereits im Planungsprozess zu berücksichtigen. Denn nur so können von Anfang an alle Parameter bedacht werden und die getroffenen Maßnahmen schließlich ihre volle Wirkung entfalten.

ln/Matthias Reidans, Senior Projektmanager Services bei Rosenberger OSI